Dans l’ère du numérique, où nos vies sont de plus en plus dominées par les ordinateurs, smartphones et autres gadgets électroniques, le terme « bit » est couramment utilisé. Mais qu’est-ce que c’est exactement ? Plongeons dans l’univers fascinant des bits pour démystifier ce concept fondamental de l’informatique.

Origines du terme « bit »

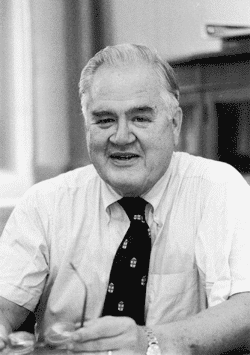

Le monde très informatisé dans lequel nous vivons aujourd’hui repose sur des concepts qui, bien que semblant simples et élémentaires, ont des origines historiques profondes et fascinantes. L’un de ces concepts est le « bit », et son histoire est intrinsèquement liée à celle de Claude Shannon, un homme dont les idées ont jeté les bases de l’ère technologique :

Claude Shannon : Le Père de la Théorie de l’Information

Né en 1916 dans le Michigan, Claude Shannon était un mathématicien, ingénieur électrique et cryptographe. Bien que ses contributions soient nombreuses, il est surtout connu pour son travail révolutionnaire sur la théorie de l’information.

En 1948, Shannon publie un article intitulé « A Mathematical Theory of Communication » (Une théorie mathématique de la communication) dans lequel il introduit le concept de « bit » comme une unité fondamentale d’information. Son travail démontre que toute information, qu’il s’agisse de texte, d’images, de son ou de tout autre type de données, peut être réduite à une séquence de 0 et de 1, c’est-à-dire à des bits.

La genèse du terme « bit »

Shannon n’a pas directement inventé le terme « bit ». En réalité, c’est John W. Tukey, un autre scientifique renommé, qui a proposé le terme « bit » comme contraction du terme « binary digit« . Cependant, c’est le travail de Shannon qui a donné au bit sa signification et son importance en tant que mesure fondamentale de l’information.

L’impact historique du bit

La conceptualisation du bit a été une avancée majeure pour plusieurs raisons :

- Standardisation : Avant Shannon, il n’y avait pas de mesure standardisée de l’information. Le bit a fourni une unité universelle qui pouvait être appliquée à n’importe quelle forme de données ;

- Digitalisation : Avec le concept du bit, il est devenu possible de représenter n’importe quelle information sous forme numérique. Cela a ouvert la porte à la création d’ordinateurs qui pourraient traiter et stocker de vastes quantités d’informations ;

- Compression et Transmission : La théorie de l’information de Shannon a également posé les bases de la compression des données, essentielle pour stocker et transmettre efficacement l’information dans notre monde connecté.

La simplicité dans la complexité

Au premier abord, le bit, cette unité fondamentale de l’information, semble être d’une simplicité trompeuse. Mais cette simplicité est précisément ce qui permet une complexité et une flexibilité incroyables dans le monde informatique. Explorons comment un élément aussi basique que le bit peut conduire à une profusion d’applications et de représentations.

Les fondements binaires : 0 et 1

La nature binaire du bit, qui n’admet que deux états, 0 ou 1, est en réalité un reflet des systèmes sur lesquels les ordinateurs sont construits (voir notre sujet sur le système binaire). Ces deux états peuvent être vus comme une représentation des deux états fondamentaux de l’électronique : le courant passe (ON) ou le courant ne passe pas (OFF). C’est cette nature ON/OFF qui est parfaitement capturée par les bits.

La puissance de la combinaison

Si un bit seul a seulement deux états possibles, en combinant plusieurs bits, on obtient une explosion des possibilités :

- Avec 2 bits: 4 combinaisons possibles (00, 01, 10, 11) ;

- Avec 3 bits: 8 combinaisons possibles (000, 001, 010, 011, 100, 101, 110, 111) ;

- …

Et ainsi de suite. Chaque bit supplémentaire double le nombre de combinaisons possibles.

L’Octet : Une combinaison puissante

L’un des groupements de bits les plus couramment utilisés est l’octet, qui est constitué de 8 bits. Comme mentionné précédemment, un octet peut représenter 256 valeurs différentes. Pour comprendre pourquoi, considérons la mathématique :

2^8 = 256

Cela signifie que, avec 8 emplacements de bits qui peuvent être soit un 0, soit un 1, il existe 256 combinaisons uniques. De 00000000 à 11111111, ces combinaisons couvrent toutes les valeurs possibles de 0 à 255.

Au-delà des nombres : La représentation de l’information

Bien que les combinaisons de bits puissent représenter des nombres, leur application ne s’arrête pas là. Par exemple, en utilisant des systèmes de codage comme le codage ASCII, chaque combinaison d’octets peut correspondre à un caractère, qu’il s’agisse d’une lettre, d’un chiffre ou d’un symbole. Ainsi, le texte que vous lisez maintenant est stocké, transmis et affiché en utilisant des combinaisons d’octets.

Les Préfixes du Bit : De Mega à Giga et Au-delà

Dans le domaine de l’informatique et des télécommunications, les termes tels que « bit », « byte » (octet en français), « megabit », « gigabyte », et d’autres sont couramment utilisés pour quantifier et exprimer la capacité de stockage ou le débit de transmission des données. Mais que signifient réellement ces préfixes et comment se situent-ils les uns par rapport aux autres ? Plongeons dans le monde des multiples du bit pour le découvrir à partir de l’unité fondamentale Bit (b) :

De Bit à Byte

Il est important d’aller plus loin avec la notion de « Byte » :

Byte (B) / Octet (o) : Un byte ou un octet est constitué de 8 bits. C’est souvent l’unité utilisée pour mesurer la capacité de stockage. Il est important de distinguer entre bit (b) et byte (B) car un byte équivalant à 8 bits, une valeur exprimée en bytes sera 8 fois plus grande que la même valeur exprimée en bits.

Le Méga

Le méga, c’est :

- Megabit (Mb) : Équivalent à 1 million de bits ou 1 000 000 bits ;

- Megabyte (MB) : Équivalent à 1 million de bytes ou 8 millions de bits, car chaque byte contient 8 bits.

Le Giga

Le Giga, c’est :

- Gigabit (Gb) : Équivalent à 1 milliard de bits ou 1 000 000 000 bits ;

- Gigabyte (GB) : Équivalent à 1 milliard de bytes. Encore une fois, si l’on convertit en bits, cela revient à 8 milliards de bits.

Et au-delà…

On retrouve notamment :

- Tera : Après le Giga, nous avons le Tera. Un Terabit (Tb) est égal à 1 000 milliards de bits, et un Terabyte (TB) est équivalent à 1 000 milliards de bytes ;

- Peta : Un ordre de grandeur encore plus grand. Un Petabit (Pb) équivaut à 1 million de milliards de bits, tandis qu’un Petabyte (PB) équivaut à 1 million de milliards de bytes ;

- Exa, Zetta, Yotta : Ces termes représentent des valeurs encore plus grandes, avec chaque terme multipliant le précédent par 1 000.

Pourquoi est-ce si important ?

L’univers des ordinateurs, malgré son apparente complexité, repose sur des principes fondamentaux simples. Au cœur de cette simplicité se trouve le bit, une unité d’information qui, bien que modeste, joue un rôle inestimable dans le fonctionnement des systèmes informatiques. Pourquoi cette unité si élémentaire est-elle si fondamentale pour nos technologies avancées ? La réponse se trouve dans la nature intrinsèque des machines que nous utilisons.

Les fondements des circuits électroniques

Pour comprendre la primauté du bit, il faut d’abord regarder les bases des systèmes électroniques modernes. Les ordinateurs, dans leur essence, sont composés de circuits électroniques. Ces circuits, souvent appelés « transistors », fonctionnent selon des principes binaires : ils peuvent soit permettre le passage du courant (état ON ou « haut ») soit le bloquer (état OFF ou « bas »).

Cette conception binaire des circuits électroniques n’est pas le fruit du hasard. Elle découle de la nécessité d’avoir un système stable et fiable, où il n’y a que deux états clairement définis. Dans un monde dominé par l’analogique, où il existe un spectre continu de valeurs, la binarité offre une résistance aux perturbations, garantissant ainsi que l’information est traitée et stockée sans ambigüité.

Le Bit : Une réflexion parfaite de la logique binaire

Si on se penche sur le concept du bit, on voit rapidement qu’il est l’équivalent numérique de cette logique binaire des circuits électroniques. Un bit, capable de prendre les valeurs 0 ou 1, est une représentation directe des deux états possibles d’un transistor : OFF ou ON.

C’est cette correspondance directe qui rend le bit si précieux. Lorsque les ordinateurs exécutent des programmes, manipulent des données ou effectuent des opérations, ils le font en manipulant ces bits, qui, à leur tour, reflètent des changements d’états dans des milliards de transistors.

Des opérations simples pour une complexité énorme

Les opérations fondamentales que les ordinateurs peuvent effectuer sur les bits sont étonnamment simples : ET, OU, NON, etc. Mais en combinant ces opérations de base dans des séquences et des structures plus élaborées, les ordinateurs peuvent réaliser des tâches incroyablement complexes, du rendu graphique à la recherche sur Internet, en passant par l’intelligence artificielle.

Au-delà des ordinateurs

Quand on pense au mot « bit », l’image qui nous vient souvent à l’esprit est celle d’un ordinateur ou d’un serveur clignotant. Cependant, la portée du bit dépasse largement le cadre des machines sur nos bureaux. Dans notre monde hyper-connecté, le bit joue un rôle central non seulement dans le fonctionnement des ordinateurs, mais aussi dans la façon dont nous communiquons, échangeons des informations et même dans la manière dont nous percevons le monde numérique autour de nous.

Les autoroutes de l’information

Imaginez les informations sous forme de voitures circulant sur une autoroute. Le nombre de voitures qui peuvent passer à un point donné en une heure déterminera la capacité de cette autoroute. De la même manière, dans le monde numérique, le « débit » est cette autoroute, et les « bits » sont ces voitures.

Le débit, mesuré en bits par seconde (bps), est un indicateur crucial de la performance d’un réseau. Qu’il s’agisse de télécharger un film, de jouer à un jeu en ligne ou de passer un appel vidéo, la quantité de bits que vous pouvez envoyer ou recevoir en une seconde détermine la qualité et la rapidité de votre expérience.

La révolution de la communication

La notion de débit a radicalement changé notre compréhension de la communication. Au début de l’ère numérique, les débits étaient relativement faibles. Les premiers modems domestiques, par exemple, avaient un débit de seulement quelques kilobits par seconde (Kbps). Aujourd’hui, avec la fibre optique et les technologies 5G, nous parlons de gigabits par seconde (Gbps), soit des milliards de bits chaque seconde !

Cette explosion du débit a rendu possible la transmission de données massives en temps réel, permettant des innovations comme le streaming vidéo en haute définition, les jeux en ligne sans décalage, et même la télémédecine.

Bits et société

Les bits influencent également notre économie et notre société. Les villes, par exemple, aspirent à avoir des connexions plus rapides pour attirer les entreprises technologiques. Les pays investissent dans des infrastructures pour augmenter le débit disponible pour leurs citoyens, reconnaissant l’importance de l’accès rapide à l’information pour l’éducation, les affaires et plus encore.

De plus, avec l’émergence de l’Internet des Objets (IoT), tout, des réfrigérateurs aux montres intelligentes, communique via des bits, rendant notre environnement quotidien de plus en plus connecté et intelligent.

En conclusion

Le bit, bien qu’étant la plus petite unité d’information, joue un rôle monumental dans le fonctionnement et l’évolution de notre monde numérique. De la capacité de stockage de nos disques durs à la vitesse de nos connexions Internet, le bit est au cœur de presque tous les aspects de notre technologie moderne. En comprenant ce qu’est un bit, nous nous rapprochons un peu plus de la compréhension de la magie qui alimente notre ère numérique.

D.A.